ОЦЕНКА ПЕРЕМЕННЫХ ПАРАМЕТРОВ

Рассмотрим теперь многошаговый процесс получения данных наблюдения и принятия решений, к которому сводятся многие практические задачи, в частности, задачи фильтрации.

Пусть для любого n-го шага (  ) совокупность данных наблюдения описывается вектором

) совокупность данных наблюдения описывается вектором  , каждая компонента которого

, каждая компонента которого  зависит от параметра

зависит от параметра  . Значения

. Значения  меняются от шага к шагу, а их совокупность для n-го шага описывается вектором

меняются от шага к шагу, а их совокупность для n-го шага описывается вектором  увеличивающейся размерности. Задача статистического решения заключается в том, чтобы на каждом n-м шаге (

увеличивающейся размерности. Задача статистического решения заключается в том, чтобы на каждом n-м шаге (  ) с помощью

) с помощью  оценить значение

оценить значение  . Последовательность этих оценок для каждого фиксированного значения п дает оценку вектора

. Последовательность этих оценок для каждого фиксированного значения п дает оценку вектора  в целом, причем каждая его компонента

в целом, причем каждая его компонента  (

(  ) оценивается с соблюдением принципа физической реализуемости, то есть зависит только от тех данных наблюдения, которые получены до

) оценивается с соблюдением принципа физической реализуемости, то есть зависит только от тех данных наблюдения, которые получены до  -ro шага включительно. При этом, как всегда,

-ro шага включительно. При этом, как всегда,  и

и  , вообще говоря, являются векторами той или иной (одинаковой или разной) размерности.

, вообще говоря, являются векторами той или иной (одинаковой или разной) размерности.

В практических приложениях индекс  чаще всего соответствует дискретному времени, a

чаще всего соответствует дискретному времени, a  - значению некоторой функции

- значению некоторой функции  в момент времени

в момент времени  . При этом полученная оценка является оценкой функции

. При этом полученная оценка является оценкой функции  в дискретных точках. При переходе к непрерывному времени вектор

в дискретных точках. При переходе к непрерывному времени вектор  переходит в отрезок реализации наблюдаемого процесса

переходит в отрезок реализации наблюдаемого процесса  на интервале времени от

на интервале времени от  до

до  , вектор

, вектор  - в отрезок реализации процесса

- в отрезок реализации процесса  на том же интервале, а задача статистического решения заключается в том, чтобы на основании наблюдения

на том же интервале, а задача статистического решения заключается в том, чтобы на основании наблюдения  на интервале

на интервале  оценить значение

оценить значение  для каждого момента времени t, большего

для каждого момента времени t, большего  и меньшего некоторого

и меньшего некоторого  , соответствующего прекращению процесса оценивания.

, соответствующего прекращению процесса оценивания.

Пусть последовательность  обладает марковским свойством, то есть для любого п

обладает марковским свойством, то есть для любого п

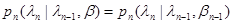

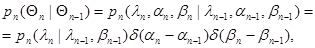

(10.4.1)

(10.4.1)

где  - переходная плотность вероятности, зависящая от совокупности неизвестных параметров

- переходная плотность вероятности, зависящая от совокупности неизвестных параметров  , описывающих априорную неопределенность статистических свойств последовательности

, описывающих априорную неопределенность статистических свойств последовательности  Выбором соответствующей размерности вектора

Выбором соответствующей размерности вектора  и подходящей совокупности параметров

и подходящей совокупности параметров  практически всегда можно добиться того, что соотношение (10.4.1) выполняется. Будем считать также, что условное математическое ожидание

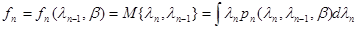

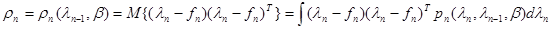

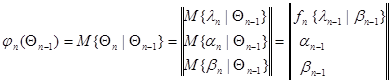

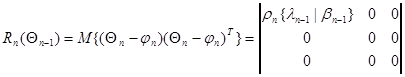

практически всегда можно добиться того, что соотношение (10.4.1) выполняется. Будем считать также, что условное математическое ожидание

(10.4.2)

(10.4.2)

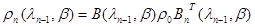

и условная корреляционная матрица

(10.4.3)

(10.4.3)

существуют, причем функция  дифференцируема по

дифференцируема по  и

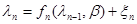

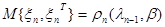

и  . Важным частным случаем, для которого выполняются условия (10.4.1) – (10.4.3), являются процессы, описываемые рекуррентным соотношением

. Важным частным случаем, для которого выполняются условия (10.4.1) – (10.4.3), являются процессы, описываемые рекуррентным соотношением

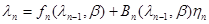

,

,  (10.4.4)

(10.4.4)

где  ,

,  ,… - последовательность независимых векторных случайных величин с корреляционной матрицей

,… - последовательность независимых векторных случайных величин с корреляционной матрицей

, (10.4.5)

, (10.4.5)

Отметим, что последняя может быть вырожденной и может содержать нулевые диагональные элементы, что соответствует несобственному условному распределению вероятности вектора  , целиком сосредоточенному на некоторых гиперповерхностях пространства, в котором задан этот вектор. Наряду с (10.4.4) часто также используется соотношение

, целиком сосредоточенному на некоторых гиперповерхностях пространства, в котором задан этот вектор. Наряду с (10.4.4) часто также используется соотношение

. (10.4.6)

. (10.4.6)

где  - случайный вектор, размерность которого не обязательно совпадает с размерностью

- случайный вектор, размерность которого не обязательно совпадает с размерностью  , имеющий корреляционную матрицу

, имеющий корреляционную матрицу  , не зависящую от

, не зависящую от  и

и  , а

, а  - прямоугольная матрица соответствующих размеров. В этом случае

- прямоугольная матрица соответствующих размеров. В этом случае

. (10.4.7)

. (10.4.7)

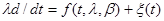

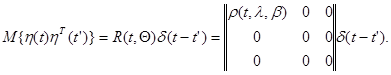

При переходе к непрерывному времени аналогом рекуррентного соотношения (10.4.4) является стохастическое дифференциальное уравнение

, (10.4.8)

, (10.4.8)

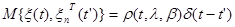

где  - дельта-коррелированный процесс («белый» шум) с корреляционной функцией

- дельта-коррелированный процесс («белый» шум) с корреляционной функцией

. (10.4.9)

. (10.4.9)

При дискретизации этого уравнения мы, очевидно, возвращаемся к рекуррентному соотношению (10.4.4), в котором при достаточно малых

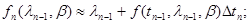

, (10.4.10)

, (10.4.10)

а условная плотность вероятности (10.4.1) является гауссовой.

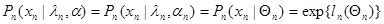

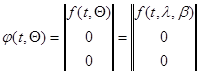

Будем считать также, что наряду с неопределенностью статистического описания переменного параметра  , подлежащего оценке, существует априорная неопределенность в отношении данных наблюдения, которая приводит к заданию распределения вероятности величин

, подлежащего оценке, существует априорная неопределенность в отношении данных наблюдения, которая приводит к заданию распределения вероятности величин  с точностью до совокупности неизвестных параметров

с точностью до совокупности неизвестных параметров  , то есть для любого

, то есть для любого

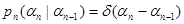

. (10.4.11)

. (10.4.11)

Набор плотностей вероятности (10.4.1) и (10.4.11) для  дает параметрически неопределенное статистическое описание задачи. В соответствии с общими результатами гл. 6 адаптивное байесово правило решения интересующей нас задачи заключается в формировании совместной оценки величин

дает параметрически неопределенное статистическое описание задачи. В соответствии с общими результатами гл. 6 адаптивное байесово правило решения интересующей нас задачи заключается в формировании совместной оценки величин  ,

,  и

и  . Для того чтобы добиться единообразия в формулировке этой задачи совместной оценки, припишем параметрам

. Для того чтобы добиться единообразия в формулировке этой задачи совместной оценки, припишем параметрам  и

и  также индекс «n», формально рассматривая их как меняющиеся от шага к шагу. Чтобы при этом не исказить существа дела, связанного с их фактической неизменностью, необходимо считать, что их последовательные значения

также индекс «n», формально рассматривая их как меняющиеся от шага к шагу. Чтобы при этом не исказить существа дела, связанного с их фактической неизменностью, необходимо считать, что их последовательные значения  ,

,  и

и  ,

,  связаны между собой соотношениями

связаны между собой соотношениями

. (10.4.12)

. (10.4.12)

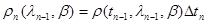

С учетом (10.4.12) мы, очевидно, имеем право записать

(10.4.13)

(10.4.13)

и

, (10.4.14)

, (10.4.14)

поскольку в силу (10.4.12) безразлично, какой индекс приписать  и

и  . Очевидно, также, что выражения (10.4.12) являются частным случаем рекуррентного соотношения (10.4.4) и им можно поставить в соответствие переходные плотности вероятности

. Очевидно, также, что выражения (10.4.12) являются частным случаем рекуррентного соотношения (10.4.4) и им можно поставить в соответствие переходные плотности вероятности

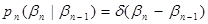

;

;

. (10.4.15)

. (10.4.15)

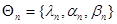

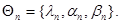

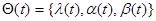

Объединим теперь параметры  ,

,  ,

,  в единую совокупность, введя вектор

в единую совокупность, введя вектор

. (10.4.16)

. (10.4.16)

суммарной размерности. Последовательность  , очевидно, удовлетворяет марковскому свойству и имеет переходную плотность вероятности

, очевидно, удовлетворяет марковскому свойству и имеет переходную плотность вероятности

(10.4.17)

(10.4.17)

причем, условное математическое ожидание и условная корреляционная матрица  , соответственно равны

, соответственно равны

, (10.4.18)

, (10.4.18)

. (10.4.19)

. (10.4.19)

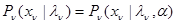

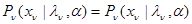

Аналогично плотность распределения вероятности для наблюдаемого значения  (10.4.13) можно записать:

(10.4.13) можно записать:

, (10.4.20)

, (10.4.20)

имея в виду, что она зависит от части из совокупности параметров

С помощью этих нехитрых операций так же, как в случае задачи оценки постоянных параметров, мы добились полного устранения формальных различий между интересующими нас полезными параметрами  и «мешающими» параметрами

и «мешающими» параметрами  и

и  , описывающими априорную неопределенность. По форме задача свелась к байесовой оценке вектора

, описывающими априорную неопределенность. По форме задача свелась к байесовой оценке вектора  с переходной плотностью вероятности (10.4.17) по совокупности наблюдаемых данных

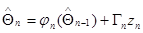

с переходной плотностью вероятности (10.4.17) по совокупности наблюдаемых данных  , каждое из которых имеет распределение вероятности с плотностью (10.4.20). Решение этой задачи хорошо известно и в асимптотическом гауссовом приближении для апостериорной плотности вероятности

, каждое из которых имеет распределение вероятности с плотностью (10.4.20). Решение этой задачи хорошо известно и в асимптотическом гауссовом приближении для апостериорной плотности вероятности  задается следующей системой рекуррентных соотношений, обеспечивающих последовательное вычисление оценочных значений

задается следующей системой рекуррентных соотношений, обеспечивающих последовательное вычисление оценочных значений  параметра

параметра  и апостериорной корреляционной матрицы

и апостериорной корреляционной матрицы  , характеризующей ошибки оценивания:

, характеризующей ошибки оценивания:

, (10.4.21)

, (10.4.21)

, (10.4.22)

, (10.4.22)

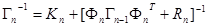

где

; (10.4.23)

; (10.4.23)

; (10.4.24)

; (10.4.24)

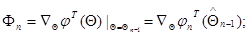

(10.4.25)

(10.4.25)

(10.4.26)

(10.4.26)

а функции  ,

,  ,

,  определяются выражениями (10.4.18) - (10.4.20) соответственно.

определяются выражениями (10.4.18) - (10.4.20) соответственно.

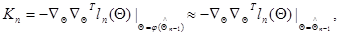

Рекуррентные соотношения (10.4.21), (10.4.22) являются обобщением рекуррентных соотношений гл. 7 для оценок максимального правдоподобия постоянных параметров. Как и в гл. 7, при вычислении весовой матрицы

(10.4.27)

(10.4.27)

практически без ухудшения точности оценки параметра  можно заменить в соотношении (10.4.22) матрицу

можно заменить в соотношении (10.4.22) матрицу  матрицей

матрицей

, (10.4.28)

, (10.4.28)

получающуюся подстановкой значения  или

или  в матрицу

в матрицу  , определенную выражением

, определенную выражением

. (10.4.29)

. (10.4.29)

Выбор начальных условий для рекуррентных соотношений (10.4.21), (10.4.22) осуществляется так же, как для рекуррентных соотношений гл. 7 с учетом ограниченных сведений об априорном разбросе значений  при

при  , если последние имеются, и нулевыми для

, если последние имеются, и нулевыми для  и

и  при

при  , если всякая информация о начальных значениях отсутствует. Как и в случае постоянных параметров, если только начиная с некоторого п матрица

, если всякая информация о начальных значениях отсутствует. Как и в случае постоянных параметров, если только начиная с некоторого п матрица  становится невырожденной и существует обратная ей матрица

становится невырожденной и существует обратная ей матрица  , то есть действительно имеется возможность измерения всех компонент параметра

, то есть действительно имеется возможность измерения всех компонент параметра  , то начальные условия быстро забываются и очень слабо влияют на значения оценок

, то начальные условия быстро забываются и очень слабо влияют на значения оценок  и характеристики их точности. В связи с этим при полном отсутствии априорных сведений для начальных значений можно задавать матрицу

и характеристики их точности. В связи с этим при полном отсутствии априорных сведений для начальных значений можно задавать матрицу  любым подходящим способом, обеспечивающим обращение матриц в (10.4.22) на начальных шагах, с соблюдением единственного условия, чтобы собственные числа матрицы

любым подходящим способом, обеспечивающим обращение матриц в (10.4.22) на начальных шагах, с соблюдением единственного условия, чтобы собственные числа матрицы  , которые характеризуют априорный разброс начальных значений

, которые характеризуют априорный разброс начальных значений  , были достаточно большими.

, были достаточно большими.

Для улучшения скорости сходимости рекуррентной процедуры и уменьшения влияния произвола в выборе начальных условий полезно более точно вычислить апостериорную плотность вероятности на начальных шагах для некоторого  , не прибегая к гауссовой аппроксимации, и затем найти то значение

, не прибегая к гауссовой аппроксимации, и затем найти то значение  , которое обращает её в максимум.

, которое обращает её в максимум.

Это максимизирующее значение  вместе с матрицей вторых производных логарифма апостериорной плотности вероятности в точке

вместе с матрицей вторых производных логарифма апостериорной плотности вероятности в точке  и являются наилучшими начальными значениями для рекуррентной процедуры, которая начинается с

и являются наилучшими начальными значениями для рекуррентной процедуры, которая начинается с  . Как правило, указанная максимизация требует решения трансцендентных уравнений, поэтому число начальных шагов следует выбирать исходя из компромисса между сложностью этих уравнений и желанием получить наиболее точное начальное приближение. Практически целесообразно выбирать

. Как правило, указанная максимизация требует решения трансцендентных уравнений, поэтому число начальных шагов следует выбирать исходя из компромисса между сложностью этих уравнений и желанием получить наиболее точное начальное приближение. Практически целесообразно выбирать  равным тому минимальному значению, для которого все компоненты максимизирующего значения

равным тому минимальному значению, для которого все компоненты максимизирующего значения  являются нетривиальными оценками вектора

являются нетривиальными оценками вектора  , то есть действительно зависят от полученных за

, то есть действительно зависят от полученных за  шагов данных наблюдения.

шагов данных наблюдения.

Если далее в процессе выполнения рекуррентной процедуры матрица  не становится особенной, то заданная система полезных параметров

не становится особенной, то заданная система полезных параметров  и параметров

и параметров  и

и  , выбранных для описания априорной неопределенности, является допустимой в том смысле, что все эти параметры действительно могут быть оценены по имеющимся данным наблюдения. Если же матрица

, выбранных для описания априорной неопределенности, является допустимой в том смысле, что все эти параметры действительно могут быть оценены по имеющимся данным наблюдения. Если же матрица  вырождается, то необходимо либо исключить часть этих параметров из числа оцениваемых, приписав им те или иные выбираемые на основе априорных предположений фиксированные значения (результат оценки остальных параметров будет зависеть оттого, сколь точно эти значения соответствуют действительным), либо расширить объем данных наблюдения, так, чтобы обеспечить возможность оценки всех имеющихся параметров.

вырождается, то необходимо либо исключить часть этих параметров из числа оцениваемых, приписав им те или иные выбираемые на основе априорных предположений фиксированные значения (результат оценки остальных параметров будет зависеть оттого, сколь точно эти значения соответствуют действительным), либо расширить объем данных наблюдения, так, чтобы обеспечить возможность оценки всех имеющихся параметров.

С точки зрения практического использования, благодаря широкому распространению ЭВМ, наибольшую ценность имеют именно рекуррентные соотношения (10.4.21), (10.4.22), которые позволяют решить громадное количество самых разнообразных прикладных задач. Однако для аналитического исследования более удобны дифференциальные уравнения, которые получаются из рекуррентных соотношений (10.4.21), (10.4.22) соответствующим предельным переходом либо могут быть найдены непосредственно при рассмотрении процессов с непрерывным временем. При этом соответствующие стохастические дифференциальные уравнения для оценок, как и исходные уравнения для оцениваемых параметров, могут пониматься либо в смысле Ито, либо в смысле Стратоновича с теми особенностями в построении схем устройств, моделирующих эти уравнения, которые следуют из различия в этом понимании. Дополняя уравнение (10.4.8) дифференциальными уравнениями для параметров  и

и

,

,  , (10.4.30)

, (10.4.30)

получаем дифференциальное уравнение для составного вектора

; (10.4.31)

; (10.4.31)

(104.33)

(104.33)

- дельта-коррелированный случайный процесс с корреляционной матрицей

(10.4.34)

(10.4.34)

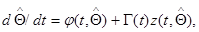

Соответствующие дифференциальные уравнения для оценки  и апостериорной корреляционной матрицы

и апостериорной корреляционной матрицы  имеют вид

имеют вид

(10.4.35)

(10.4.35)

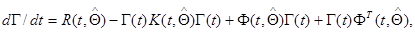

(10.4.36)

(10.4.36)

где  и

и  определяются так же, как в гл. 7 формулами (7.5.43) и (7.5.47) с возможной заменой

определяются так же, как в гл. 7 формулами (7.5.43) и (7.5.47) с возможной заменой  на

на  из (7.5.49), а матрица

из (7.5.49), а матрица  определяется соотношением

определяется соотношением

.

.

Дифференциальное уравнение для матрицы

(10.4.37)

(10.4.37)

имеет вид

(10.4.38)

(10.4.38)

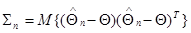

Матрица  , определяемая соотношением (10.4.22), и соответственно

, определяемая соотношением (10.4.22), и соответственно  ,определяемая дифференциальным уравнением (10.4.36), представляют собой апостериорные корреляционные матрицы оцениваемой совокупности параметров. Корреляционная матрица ошибок оценивания этих параметров

,определяемая дифференциальным уравнением (10.4.36), представляют собой апостериорные корреляционные матрицы оцениваемой совокупности параметров. Корреляционная матрица ошибок оценивания этих параметров

(10.4.39)

(10.4.39)

и соответственно

(10.4.40)

(10.4.40)

асимптотически (при достаточно большом объеме данных наблюдения или при достаточно высокой точности единичных измерений параметров  по одному наблюдению

по одному наблюдению  ) определяются теми же рекуррентными соотношениями и дифференциальными уравнениями, что

) определяются теми же рекуррентными соотношениями и дифференциальными уравнениями, что  и

и  , если в них всюду заменить оценочные значения параметров

, если в них всюду заменить оценочные значения параметров  их истинными значениями, а матрицы

их истинными значениями, а матрицы  и

и  их математическими ожиданиями

их математическими ожиданиями  и

и  соответственно. Этот факт достаточно хорошо известен для неадаптивного случая, а в силу того, что при наличии априорной неопределенности задача оценки сводится к обычной байесовой задаче относительно расширенной совокупности параметров, полностью переносится и на адаптивный случай. Указанное совпадение полностью аналогично асимптотической сходимости корреляционной матрицы ошибок оценивания постоянных параметров к матрице, обратной информационной матрице Фишера. Таким образом, приведенные выше рекуррентное соотношение (10.4.22) и дифференциальное уравнение (10.4.36) дают возможность простой подстановкой в них истинных значений оцениваемых параметров найти точность оценки этих параметров.

соответственно. Этот факт достаточно хорошо известен для неадаптивного случая, а в силу того, что при наличии априорной неопределенности задача оценки сводится к обычной байесовой задаче относительно расширенной совокупности параметров, полностью переносится и на адаптивный случай. Указанное совпадение полностью аналогично асимптотической сходимости корреляционной матрицы ошибок оценивания постоянных параметров к матрице, обратной информационной матрице Фишера. Таким образом, приведенные выше рекуррентное соотношение (10.4.22) и дифференциальное уравнение (10.4.36) дают возможность простой подстановкой в них истинных значений оцениваемых параметров найти точность оценки этих параметров.

Так же, как в §10.2, дискретный (10.4.21), (10.4.22) и непрерывный (10.4.35), (10.4.36) алгоритмы формирования оценок автоматически учитывают наличие данных обучения, описание которых производится соответствующим заданием функций правдоподобия  (и соответственно

(и соответственно  или

или  ), где под

), где под  понимается вся совокупность наблюдаемых на n-м шаге данных, возможно (при наблюдении на интервале обучения «чистых» реализаций значений измеряемого параметра) включающих в себя и значения

понимается вся совокупность наблюдаемых на n-м шаге данных, возможно (при наблюдении на интервале обучения «чистых» реализаций значений измеряемого параметра) включающих в себя и значения  .

.

Дата добавления: 2020-10-14; просмотров: 476;