Проблема мультиколлинеарности

Под полной мультиколлинеарностью понимается существование между некоторыми из факторов линейной функциональной связи. Количественным выражением этого служит то обстоятельство, ранг матрицы Х меньше, чем (р+1), а матрица (Х’Х) будет вырожденной, т.е. её определитель равен нулю, а обратной матрицы к ней не существует. В практике статистических исследований полная мультиколлинеарность встречается достаточно редко, т.к. её несложно избежать уже на предварительной стадии анализа и отбора множества объясняющих переменных.

Реальная (или частичная) мультиколлинеарность возникает в случаях существования достаточно тесных линейных статистических связей между объясняющими переменными. Точных количественных критериев для определения наличия или отсутствия реальной мультиколлинеарности не существует. Тем не менее, существуют некоторые эвристические рекомендации по выявлению мультиколлинеарности.

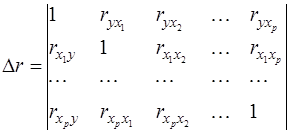

В первую очередь анализируют матрицу парных коэффициентов корреляции:

(38)

(38)

точнее, ту её часть, которая относится к объясняющим переменным. Считается, что две переменные явно коллинеарны, если  . В этом случае факторы дублируют друг друга, и один из них рекомендуется исключить из регрессии. Предпочтение при этом отдаётся фактору, который при достаточно тесной связи с результатом имеет наименьшую тесноту связи с другими факторами.

. В этом случае факторы дублируют друг друга, и один из них рекомендуется исключить из регрессии. Предпочтение при этом отдаётся фактору, который при достаточно тесной связи с результатом имеет наименьшую тесноту связи с другими факторами.

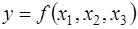

Пусть, например, при изучении зависимости  матрица парных коэффициентов корреляции оказалась следующей:

матрица парных коэффициентов корреляции оказалась следующей:

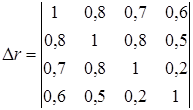

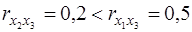

Очевидно, что факторы х1 и х2 дублируют друг друга (  ). Однако в модель следует включить фактор х2, а не х1, поскольку корреляция фактора х2 с у достаточно высокая (

). Однако в модель следует включить фактор х2, а не х1, поскольку корреляция фактора х2 с у достаточно высокая (  ), а с фактором х3 слабая (

), а с фактором х3 слабая (  ).

).

Другим методом оценки мультиколлинеарности факторов может служить определитель матрицы парных коэффициентов корреляции между факторами (37). Обоснованием данного подхода служат такие рассуждения. Если бы факторы не коррелировали между собой, то в определителе (37) все внедиагональные элементы равнялись бы нулю, а на диагонали стояли бы единицы. Такой определитель равен единице. Если же, наоборот, между факторами существует полная линейная зависимость и все коэффициенты межфакторной корреляции равны единице, то определитель такой матрицы равен нулю. Следовательно, чем ближе к нулю определитель (37), тем сильнее мультиколлинеарность факторов и ненадежнее результаты множественной регрессии. И наоборот, чем ближе к единице величина (37), тем меньше мультиколлинеарность факторов.

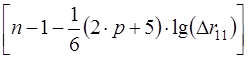

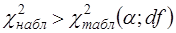

Для оценки значимости мультиколлинеарности факторов выдвигается гипотеза Н0:Δr11=1. Доказано, что величина  имеет приближенное распределение χ2 с

имеет приближенное распределение χ2 с  степенями свободы. Если

степенями свободы. Если  , то гипотеза Н0 отклоняется, мультиколлинеарность считается доказанной.

, то гипотеза Н0 отклоняется, мультиколлинеарность считается доказанной.

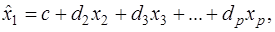

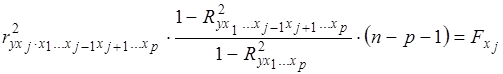

Другим методом выявления мультиколлинеарности является анализ коэффициентов множественной детерминации факторов. Для этого в качестве зависимой переменной рассматривается каждый из факторов. Например, коэффициент  рассчитывается по следующей регрессии:

рассчитывается по следующей регрессии:

где первый фактор взят в качестве результативного признака, а остальные факторы – как независимые переменные, влияющие на первый фактор. Чем ближе такой R2 к единице, тем сильнее проявляется мультиколлинеарность факторов. Оставляя в уравнении регрессии факторы с минимальной R2, можно решить проблему отбора факторов.

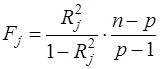

При этом рассчитывается статистика:

(39)

(39)

Если коэффициент  статистически значим, то

статистически значим, то  . В этом случае xj является линейной комбинацией других факторов, и его можно исключить из регрессии.

. В этом случае xj является линейной комбинацией других факторов, и его можно исключить из регрессии.

Основные последствия мультиколлинеарности:

1. Большие дисперсии оценок. Это затрудняет нахождение истинных значений определяемых величин и расширяет интервальные оценки, ухудшая их точность.

2. Уменьшаются t – статистики коэффициентов, что может привести к неоправданному выводу о несущественности влияния соответствующего фактора на зависимую переменную.

3. Оценки коэффициентов по МНК и их стандартные ошибки становятся очень чувствительными к малейшим изменениям данных, т.е. они становятся неустойчивыми.

4. Затрудняется определение вклада каждой из объясняющих переменных в объясняемую уравнением регрессии дисперсию зависимой переменной.

5. Возможно получение неверного знака у коэффициента регрессии.

Единого подхода к устранению мультиколлинеарности не существует. Существует ряд методов, которые не являются универсальными и применимы в конкретных ситуациях.

Простейшим методом устранения мультиколлинеарности является исключение из модели одной или нескольких коррелированных переменных. Здесь необходима осторожность, чтобы не отбросить переменную, которая необходима в модели по своей экономической сущности, но зачастую коррелирует с другими переменными (например, цена блага и цены заменителей данного блага).

Иногда для устранения мультиколлинеарности достаточно увеличить объем выборки. Например, при использовании ежегодных данных можно перейти к поквартальным данным. Это приведёт к сокращению дисперсии коэффициентов регрессии и увеличению их статистической значимости. Однако при этом можно усилить автокорреляцию, что ограничивает возможности такого подхода.

В некоторых случаях изменение спецификации модели, например, добавление существенного фактора, решает проблему мультиколлинеарности. При этом уменьшается остаточная СКО, что приводит к уменьшению стандартных ошибок коэффициентов.

В ряде случаев минимизировать либо вообще устранить проблему мультиколлинеарности можно с помощью преобразования переменных.

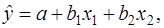

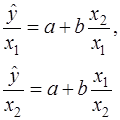

Например, пусть эмпирическое уравнение регрессии имеет вид:

где факторы коррелированы. Здесь можно попытаться определить отдельные регрессии для относительных величин:

(40)

(40)

Возможно, что в моделях, аналогичных (40), проблема мультиколлинеарности будет отсутствовать.

Частная корреляция

С помощью частных коэффициентов корреляции проводится ранжирование факторов по степени их влияния на результат. Кроме того, частные показатели корреляции широко используются при решении проблем отбора факторов: целесообразность включения того или иного фактора в модель доказывается величиной показателя частной корреляции.

Частные коэффициенты корреляции характеризуют тесноту связи между результатом и соответствующим фактором при устранении влияния других факторов, включенных в уравнение регрессии.

Показатели частной корреляции представляют собой отношение сокращения остаточной дисперсии за счет дополнительного включения в модель нового фактора к остаточной дисперсии, имевшей место до введения его в модель.

Высокое значение коэффициента парной корреляции между исследуемой зависимой и какой-либо независимой переменной может означать высокую степень взаимосвязи, но может быть обусловлено и другой причиной, например, третьей переменной, которая оказывает сильное влияние на две первые, что и объясняет их высокую коррелированность. Поэтому возникает задача найти «чистую» корреляцию между двумя переменными, исключив (линейное) влияние других факторов. Это можно сделать с помощью коэффициента частной корреляции.

Коэффициенты частной корреляции определяются различными способами. Рассмотрим некоторые из них.

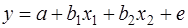

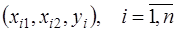

Для простоты предположим, что имеется двухфакторная регрессионная модель:

(41)

(41)

и имеется набор наблюдений  . Тогда коэффициент частной корреляции между у и, например, х1 после исключения влияния х2 определяется по следующему алгоритму:

. Тогда коэффициент частной корреляции между у и, например, х1 после исключения влияния х2 определяется по следующему алгоритму:

1. Осуществим регрессию у на х2 и константу и получим прогнозные значения  .

.

2. Осуществим регрессию х1 на х2 и константу и получим прогнозные значения  .

.

3. Удалим влияние х2, взяв остатки  и

и  .

.

4. Определим выборочный коэффициент частной корреляции между у и х1 при исключении х2 как выборочный коэффициент корреляции между ey и e1 :

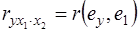

(42)

(42)

Значения частных коэффициентов корреляции лежат в интервале [-1,1], как у обычных коэффициентов корреляции. Равенство  нулю означает отсутствие линейного влияния переменной х1 на у.

нулю означает отсутствие линейного влияния переменной х1 на у.

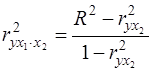

Существует тесная связь между коэффициентом частной корреляции  и коэффициентом детерминации R2:

и коэффициентом детерминации R2:

(43)

(43)

где  - обычный коэффициент корреляции.

- обычный коэффициент корреляции.

Описанная выше процедура обобщается на случай, когда исключается влияние нескольких переменных. Для этого достаточно переменную х2 заменить на набор переменных Х2, сохраняя определение (42) (при этом можно в число исключаемых переменных вводить и у, определяя частную корреляцию между факторами).

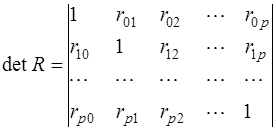

Другой способ определения коэффициентов частной корреляции – матричный. Обозначив для удобства зависимую переменную как х0, запишем определитель матрицы парных коэффициентов корреляции в виде:

(44)

(44)

Тогда частный коэффициент корреляции определяется по формуле:

, (45)

, (45)

где Rii - алгебраическое дополнение для элемента rii в определителе (44).

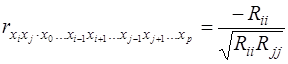

Существует ещё один способ расчета – по рекуррентной формуле. Порядок частного коэффициента корреляции определяется количеством факторов, влияние которых исключается. Например,  - коэффициент частной корреляции первого порядка. Соответственно коэффициенты парной корреляции называются коэффициентами нулевого порядка. Коэффициенты более высоких порядков можно определить через коэффициенты более низких порядков по рекуррентной формуле:

- коэффициент частной корреляции первого порядка. Соответственно коэффициенты парной корреляции называются коэффициентами нулевого порядка. Коэффициенты более высоких порядков можно определить через коэффициенты более низких порядков по рекуррентной формуле:

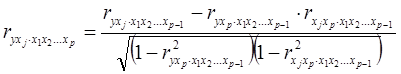

(46)

(46)

Если исследователь имеет дело лишь с тремя – четырьмя переменными, то удобно пользоваться соотношениями (46). При больших размерностях задачи удобнее расчет через определители, т.е. по формуле (45). В соответствии со смыслом коэффициентов частной корреляции можно записать формулу:

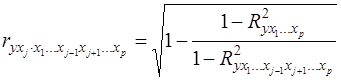

(47)

(47)

При исследовании статистических свойств выборочного частного коэффициента корреляции порядка k следует воспользоваться тем, что он распределен точно так же, как и обычный парный коэффициент корреляции, с единственной поправкой: объём выборки надо уменьшить на k единиц, т.е. полагать его равным n-k, а не n.

Пример. По итогам года 37 однородных предприятий легкой промышленности были зарегистрированы следующие показатели их работы: у – среднемесячная характеристика качества ткани (в баллах), х1 – среднемесячное количество профилактических наладок автоматической линии; х2 – среднемесячное количество обрывов нити.

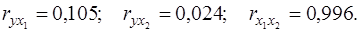

По исходным данным были подсчитаны выборочные парные коэффициенты корреляции:

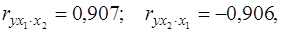

Проверка статистической значимости этих величин показала отсутствие значимой статистической связи между результативным признаком и каждым из факторов, что не согласуется с профессиональными представлениями технолога. Однако расчет частных коэффициентов корреляции дал значения:

которые вполне соответствуют нашим представлениям о естественном характере связей между изучаемыми показателями.

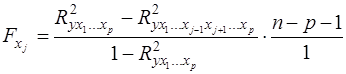

Для оценки значимости фактора, дополнительно вводимого в модель, используется частный F-критерий. Не каждый фактор, вошедший в модель, существенно увеличивает долю объясненной дисперсии в общей дисперсии результата. Кроме того, при наличии в модели нескольких факторов они могут вводиться в модель в разной последовательности. Ввиду корреляции между факторами значимость одного и того же фактора может быть разной в зависимости от последовательности его введения в модель. Для частного F – критерия используется формула:

, (50)

, (50)

которая является частным случаем формулы (32). Здесь в числителе – разность между коэффициентом детерминации модели с полным набором факторов и коэффициентом детерминации модели до введения в неё фактора xj.

С помощью частного F – критерия можно проверить значимость всех коэффициентов регрессии в предположении, что соответствующий фактор xj вводился в уравнение регрессии последним. Процедура проверки не отличается от таковой для статистики (32).

Зная величину  , можно определить и t – критерий для коэффициента регрессии при xj:

, можно определить и t – критерий для коэффициента регрессии при xj:

(51)

(51)

Существует взаимосвязь между квадратом частного коэффициента корреляции и частным F – критерием:

(52)

(52)

Частный F – критерий широко используется при построении модели методом включения переменных.

Дата добавления: 2016-07-27; просмотров: 5616;